Regularization đã trở thành một phần thiết yếu trong việc huấn luyện mạng thần kinh. Tuy nhiên, các phương pháp này không phải lúc nào cũng đủ để cải thiện hiệu suất một cách tối ưu. Những hạn chế trong việc áp dụng regularization có thể dẫn đến tình trạng dưới khớp. Có những phương pháp tiên tiến nào có thể thay thế để đạt được cả độ chính xác và khả năng tổng quát? Hãy cùng khám phá.

Những điểm chính

- Regularization không giải quyết hiệu quả vấn đề độ phức tạp mô hình và thiếu dữ liệu, dẫn đến hạn chế trong khả năng tổng quát.

- Quá nhiều regularization có thể gây underfitting, làm giảm độ chính xác của mô hình.

- Các phương pháp tiên tiến như Batch Normalization và Data Augmentation giúp cải thiện tốc độ và hiệu suất mô hình.

- Multi-task learning cho phép chia sẻ thông tin giữa các nhiệm vụ, phát triển đặc trưng mạnh mẽ hơn.

- Hàm mất mát đa mục tiêu giúp cân bằng giữa độ chính xác và khả năng tổng quát, tối ưu hóa quy trình huấn luyện.

Giới thiệu về Regularization trong huấn luyện mạng thần kinh

Regularization serves as an essential technique in the training of neural networks, aimed at preventing overfitting. Overfitting occurs when a model learns noise and peculiarities in the training data rather than the underlying patterns, leading to poor performance on unseen data. Regularization techniques introduce additional constraints or penalties during the training process, encouraging the model to generalize better. Common methods include L1 and L2 regularization, dropout, and early stopping. L1 regularization adds a penalty proportional to the absolute value of the weights, promoting sparsity in the model. Conversely, L2 regularization penalizes the square of the weights, discouraging overly complex models. Dropout randomly deactivates a subset of neurons during training, reducing reliance on any single feature. By incorporating these strategies, neural networks can achieve better generalization, enhancing their performance on real-world tasks. Regularization therefore plays a pivotal role in developing robust and effective machine learning models.

Những hạn chế của Regularization trong việc cải thiện hiệu suất

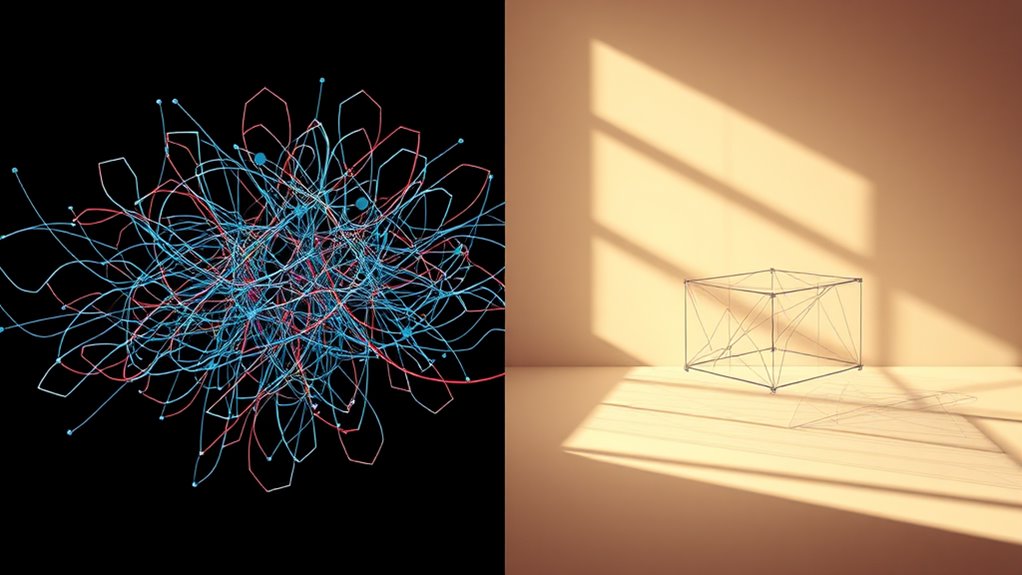

While regularization techniques are widely employed to enhance model generalization, they are not without limitations. One primary concern is that regularization may not effectively address the underlying issues of model complexity and data scarcity. As models become more sophisticated, standard regularization methods can fail to provide sufficient constraints, leading to suboptimal performance. Additionally, excessive regularization can hinder the model’s ability to capture relevant patterns in the data, resulting in underfitting.

Moreover, regularization methods often require careful tuning of hyperparameters, which can be time-consuming and may not yield the desired improvements in all scenarios. They also tend to focus primarily on preventing overfitting, neglecting the importance of optimizing for multiple objectives or enhancing the model’s robustness against adversarial attacks. Overall, these limitations underscore the need for more innovative approaches to improve neural network training beyond traditional regularization techniques.

Các phương pháp tiên tiến thay thế Regularization

Khi các phương pháp regularization truyền thống gặp khó khăn trong việc cải thiện hiệu suất của mô hình, các nhà nghiên cứu đã chuyển sang các phương pháp tiên tiến hơn để thay thế. Những phương pháp này không chỉ giúp giảm thiểu quá khớp mà còn tối ưu hóa khả năng tổng quát của mạng thần kinh. Các kỹ thuật như Dropout, Batch Normalization và Data Augmentation đã trở thành lựa chọn phổ biến.

Dưới đây là một bảng tóm tắt các phương pháp tiên tiến:

| Phương pháp | Mô tả |

|---|---|

| Dropout | Ngẫu nhiên bỏ qua một phần neuron trong mỗi lần huấn luyện. |

| Batch Normalization | Chuẩn hóa đầu vào của từng lớp để cải thiện tốc độ và độ ổn định. |

| Data Augmentation | Tạo ra các biến thể của dữ liệu huấn luyện để tăng cường hiệu suất. |

| Early Stopping | Dừng huấn luyện khi hiệu suất trên tập kiểm tra bắt đầu giảm. |

| Ensemble Methods | Kết hợp nhiều mô hình để cải thiện độ chính xác. |

Tích hợp hai mục tiêu trong huấn luyện mạng thần kinh

Tích hợp hai mục tiêu trong huấn luyện mạng thần kinh là một chiến lược quan trọng nhằm tối ưu hóa cả độ chính xác và khả năng tổng quát của mô hình. Để đạt được điều này, các nhà nghiên cứu thường áp dụng các kỹ thuật như multi-task learning, cho phép mô hình học đồng thời từ nhiều nhiệm vụ khác nhau. Thông qua việc chia sẻ thông tin giữa các nhiệm vụ, mô hình có thể phát triển các đặc trưng mạnh mẽ hơn, từ đó cải thiện hiệu suất tổng thể.

Ngoài ra, việc sử dụng các hàm mất mát đa mục tiêu cũng giúp cân bằng giữa các yếu tố như độ chính xác và tính chính xác, từ đó giảm thiểu hiện tượng overfitting. Tích hợp hai mục tiêu không chỉ nâng cao khả năng học của mạng mà còn tối ưu hóa quy trình huấn luyện, tạo ra những mô hình mạnh mẽ và hiệu quả hơn trong ứng dụng thực tế.

Ứng dụng thực tế của các phương pháp mới trong ngành công nghiệp

Các phương pháp mới trong huấn luyện mạng thần kinh đã nhanh chóng được áp dụng trong nhiều lĩnh vực công nghiệp, nhờ vào khả năng cải thiện hiệu suất và độ chính xác của các mô hình. Những ứng dụng này bao gồm nhận diện hình ảnh, xử lý ngôn ngữ tự nhiên và dự đoán tài chính. Việc áp dụng các kỹ thuật huấn luyện tiên tiến đã dẫn đến những cải thiện đáng kể trong khả năng phân loại và dự đoán.

Dưới đây là bảng tổng hợp một số ứng dụng thực tế:

| Ngành | Ứng dụng | Kỹ thuật sử dụng |

|---|---|---|

| Y tế | Chẩn đoán bệnh | Mạng nơ-ron tích chập |

| Tài chính | Dự đoán rủi ro | Học sâu |

| Giao thông | Quản lý lưu lượng | Mạng nơ-ron hồi tiếp |

| Thương mại điện tử | Gợi ý sản phẩm | Mạng nơ-ron đa lớp |